Einführung

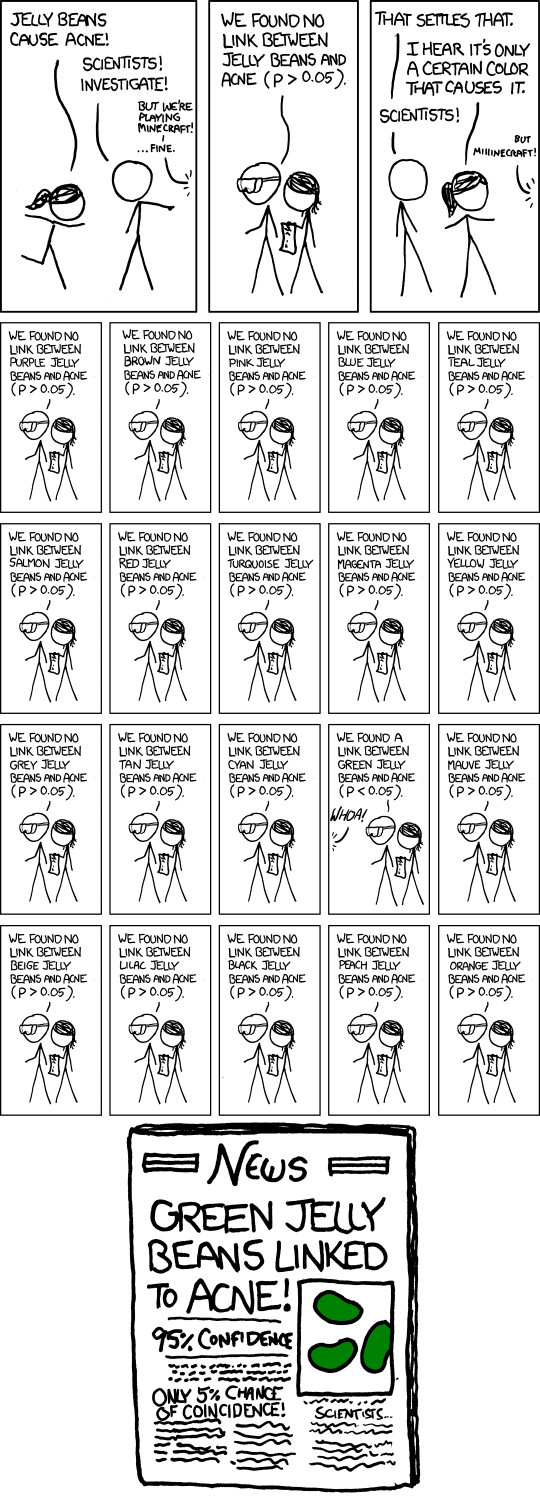

Hypothesentests (auch statistische Tests genannt) sind ein zentrales Werkzeug in vielen wissenschaftlichen Disziplinen. Sie formalisieren dabei wie Daten (durch Experimente, Studien, Befragungen, etc.) beeinflussen, ob wir eine Hypothese akzeptieren oder zurückweisen. Obwohl sie so ein wichtiges Tool sind, gibt es immer wieder Verwirrungen und fehlerhafte Anwendungen. Diese können dazu führen, dass eine neue Hypothese ungerechtfertigeterweise akzeptiert wird.

Hier wollen wir uns auf die Alphafehlerkumulierung konzentrieren. Dazu müssen wir einmal die Basics der Hypothesentests wiederholen.

Klassische Hypothesentests vergleichen zwei Hypothesen, wobei diese nicht gleichberechtigt sind. Es gibt einmal die sog. Nullhypothese (Abkürzung: . Die Nullhypothese beschreibt die Welt, so wie wir momentan glauben, dass sie ist. Die Nullhypothese ist also der Default, bei dem wir ohne weitere Daten bleiben würden. Die zweite Hypothese ist die Alternativhypothese (Abkürzung: oder ). Diese akzeptieren wir nur, wenn die Daten nicht zu unserer Nullhypothese passen. Spannend dabei (und auch ein Kritikpunkt an Hypothesentests) ist, dass Hypothesentests eigentlich nur untersuchen wie wahrscheinlich die Daten unter der Nullhypothese sind und falls diese ausreichend unwahrscheinlich sind die Nullhypothese zurückweist. Wir entscheiden uns also nicht aktiv für die Alternativhypothese, sondern gegen die Nullhypothese. Häufig spielt diese Unterscheidung keine Rolle, da die Nullhypothese und Alternativhypothese komplementär zueinander gewählt wurden. Falls die Alternativhypothese nicht komplementär ist (was bad practice ist), wird die Unterscheidung relevant. Solche “Kniffe” können verwendet werden, um eine Agenda zu pushen.

Der Test soll nun entscheiden, ob wir bei der Nullhypothese verbleiben oder diese zurückweisen. Hypothesentests können dies nicht mit absoluter Sicherheit, deshalb gibt es vier Fälle die auftreten können:

Die Diagonalen sind dabei die guten Fälle: Wir akzeptieren die Nullhypothese, falls sie zutrifft und weisen sie zurück, falls sie nicht zutrifft. Problematisch ist die Gegendiagonale. Hier verbleiben wir entweder bei der Nullhypothese, ob wohl die Alternative zutrifft (Fehler 2. Art oder Betafehler) oder umgekehter (Fehler 1. Art oder Alphafehler). In der Wissenschaft wird generell gefordert, dass wir sicher sind, dass wir wirklich einen neuen Effekt gefunden haben, bevor wir ihn reporten. Das könnte man als gängige Praxis bezeichnen. Übersetzt auf Hypothesentests bedeutet das, dass wir Alphafehler am liebsten komplett eliminieren würden. Das ist aber häufig mathematisch unmöglich. Stattdessen soll der Alphafehler hinreichend klein sein. Eine weitverbreitete (allerdings auch häufig kritisierte) Schranke ist 0.05. Diese Schranke wird als Signifikanzniveau bezeichnet. Beim Hypothesentest werden die Daten mit der Nullhypothese verglichen und es wird berechnet, wie wahrscheinlich die Daten auftreten, unter der Annahme das die Nullhypothese gilt. Diese Wahrscheinlichkeit wird als p-Wert bezeichnet. Ist der p-Wert kleinergleich als das Signifikanzniveau, so ist die Wahrscheinlichkeit einen Alphafehler zu machen kleiner als die geforderte Schranke und die Nullhypothese wird verworfen. In dem Fall wird von einem statistisch signifikanten Ergebnis besprochen. Mathematisch heißt das einfach nur, dass der p-Wert kleiner als das gewählte Signifikanzniveau ist.

In der Theorie ist damit zunächst alles über Hypothesentest gesagt. Leider ist die Realität etwas chaotischer als dieser einfache Framework vorgaukelt. Denn häufig weiß man zu Beginn eines Forschungsprojekts gar nicht welche Hypothese man eigentlich testen soll. Man untersucht also erstmal explorativ die Daten bis sich eine Hypothese auftut. Dann testet man sie. Falls das nicht passt, sucht man weiter. Wie das zu Probleme führen kann, wollen wir uns in folgendem (Gedanken-)Experiment (pun intended) anschauen.

Experiment

- Tim behauptet er kann hellsehen. Das ist natürlich weit hergeholt und die Nullhypothese wäre, dass er das nicht kann. Er schlägt aber ein Experiment vor, um euch vom Gegenteil zu überzeugen: Ihr würfelt einen 20-seitigen Würfel, ohne dass Tim das Ergebnis sieht. Ihr notiert das Ergebnis und falls Tim euch das Würfelergebnis sagen kann, dann muss er ein Hellseher sein (zum Signifikanzniveau 0.05).

- Was sind Null- und Alternativhypothese?

- Wie hoch ist die Wahrscheinlichkeit, dass er die richtige Zahl sagt, falls er nicht hellsehen kann? Diese Wahrscheinlichkeit ist der p-Wert des Experiments für den Fall, dass Tim die richtige Zahl nennt.

- Vermutlich hat sich Tim als Hochstapler entpuppt. Allerdings behauptet er jetzt, dass es mindestens eine*n Hellseher*in in diesem Workshop gibt. Er schlägt vor das gleiche Experiment mit jedem Teilnehmenden zu wiederholen, um die/den Hellsehenden zu identifizieren.

- Was sind Null- und Alternativhypothese?

- Tim behauptet, da der Test für jede einzelne Person zum Signifikanzniveau 0.05 funktioniert, hat der globale Test für alle Teilnehmenden auch ein Signifikanzniveau von 0.05. Warum ist die Aussage quatsch? Optional: Falls ihr Lust auf Rechnen habt, was wäre die Wahrscheinlichkeit, dass ein Teilnehmender zufällig die richtige Zahl rät? Ansonsten schaut euch mal diese Tabelle an:

Untitled

Untitled - Aufbauend auf der vorherigen Frage: Was bedeteutet Alphafehlerkumulierung?

- Ein Experiment in diesem Stil wird als ‘Multiple Hypothesis Testing’ bezeichnet. Welche multiplen Hypothesen werden getestet?

- Wie könnt ihr das Experiment verändern, so dass das Signifikanzniveau von 0.05 eingehalten wird?

Erläuterungen

Wenn auf dem gleichen Datensatz mehrere Hypothesen getestet werden und jede nur eine geringe Wahrscheinlichkeit hat zuzutreffen, so steigt doch mit jeder weiteren Hypothese die Wahrscheinlichkeit, dass zumindest eine davon zutrifft. Dieser Effekt wird als Alphafehlerkumulierung bezeichnet und ist ein subtiles, aber ernstzunehmendes Problem im aktuellen wissenschaftlichen Betrieb. Neue Daten sind teuer. Also muss das Letzte aus jedem Datensatz herausgeholt werden. Das lädt dazu ein möglichst viele Hypothesen auf dem Datensatz zu testen mit der Konsequenz, dass man sehr wahrscheinlich einen signifikanten Effekt findet, der aber wahrscheinlich keinen kausalen Ursprung hat, sondern einfach auf Rauschen in den Daten zurückzuführen ist. Falls tatsächlich nur der Datensatz zur Verfügung steht, ist die einzige Möglichkeit die Signifikanzniveaus für jeden Einezltest zu verringern, so dass das global Signifikanzniveau eingehalten werden kann (siehe z.B. Bonferroni-Korrektur). Damit läuft man aber Gefahr Effekte zu übersehen. Die zweite Alternative ist nach dem eine Hypothese identifziert wurde, neue Daten aufzunehmen und dann gezielt diese eine Hypothese auf den neuen Daten zu überprüfen. Durch die unabhängigen neuen Daten gilt dann für das neue Experiment wieder das alte Signifikanzniveau. Allerdings ist auch dieser Vorgang mit Kosten verbunden.

Problematisch dabei ist, dass es als Aussenstehende*r quasi unmöglich ist zu bemerken, wie viele Hypothesen auf einem Datensatz bereits getestet wurden. Es sei denn, der/die Autor*in ist sehr transparent in seinem/ihrem Manuskript. Da dies aber im allgemeinen die Chancen für die Publikation verschlechtert, ist das eher selten der Fall…

Leitfragen

- Wie passt die obige Erklärung von Alphafehler-Kumulierung und ‘Multiple Hypothesis Testing’ zum Einführungs-Comic?

- Was hat die Website “Spurious Correlations” mit Alphafehler-Kumulierung zu tun?

- Was könnten Anzeichen dafür sein, dass ein Fall von Multiple Hypothesis Testing vorliegt? Welche Eigenschaften könnten Datensätze haben, die besonders dazu einladen?

- Wie kann das Anmelden von Studien in Studienregistern dazu beitragen Alphafehlerkumulierung zu verhindern?